Việc giảm kích thước có thể được mô tả rất đơn giản bằng cách sử dụng hình ảnh bên dưới. Đó là mô tả về việc trừu tượng hóa những cây khác nhau và phức tạp thành cây đơn giản nhất. chỉ cần giảm kích thước là biết đó là một cái cây.

Giảm kích thước thực chất là tìm một hàm sao cho đầu vào x dẫn đến đầu ra z và thứ nguyên của đầu ra z nhỏ hơn thứ nguyên của đầu vào x. Có một số khía cạnh cụ thể. Hãy bắt đầu với PCA (Phân tích thành phần chính).

PCA

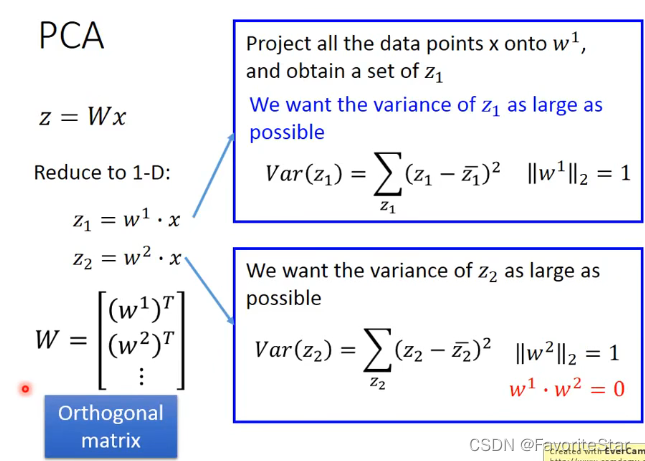

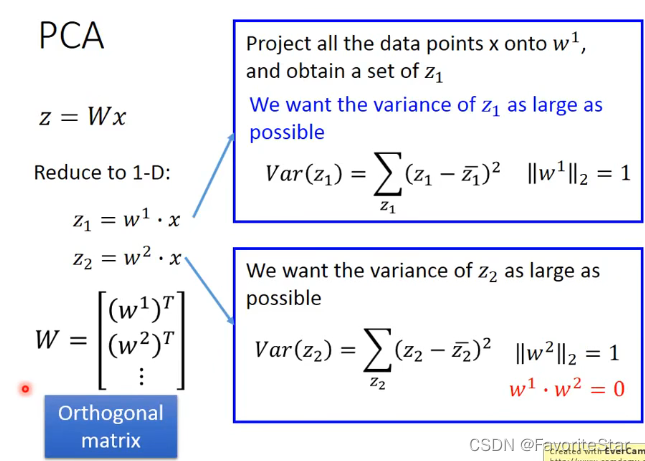

PCA tin rằng hàm số thực sự có thể được xem như một ma trận, nghĩa là:

\[z=Wx\]

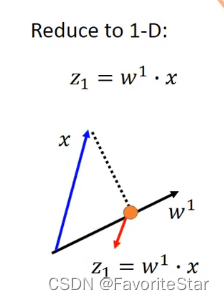

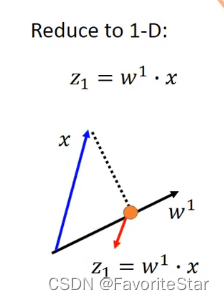

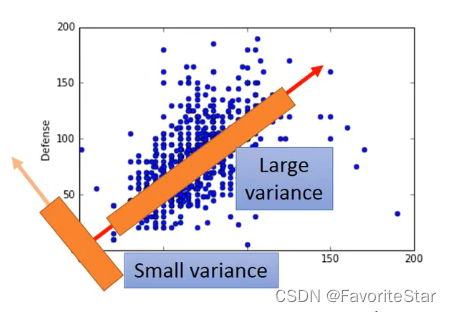

Điều này có thể được mô tả thông qua phép toán vectơ và ma trận. Khi đó hiện nay giả sử x là vectơ hai chiều và cần phải rút gọn nó thành vectơ một chiều z và chuẩn của w bằng 1 thì z có thể coi là hình chiếu của x trên w.

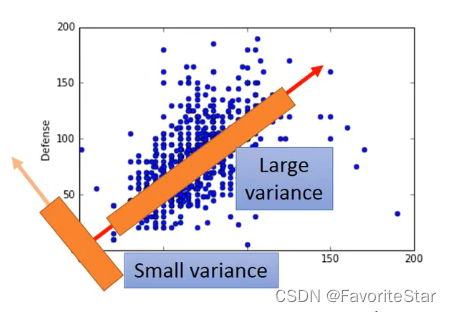

W theo các hướng khác nhau sẽ làm cho z được chiếu khác nhau, vì vậy mục tiêu của chúng ta là tìm ra một w có thể tối đa hóa sự khác biệt về z sau khi chiếu, thay vì bị chen chúc nhau như hình dưới đây:

Điều tương tự cũng đúng nếu nó được giảm xuống nhiều thứ nguyên. Trước tiên, hãy tìm một thứ nguyên nhất định có thể tối đa hóa phương sai tương ứng, sau đó tìm một thứ nguyên khác có thể tối đa hóa phương sai tương ứng và \(w^2\) và \(w^1). \) là trực giao, v.v.:

\(W\) cuối cùng là ma trận trực giao.

Sau một loạt phép đạo hàm (bạn có thể xem video về phần đạo hàm này và tôi cũng sẽ thêm quy trình đạo hàm vào phương pháp học thống kê sau), kết luận là: Giả sử rằng ma trận hiệp phương sai của x là\(S= Cov(x) \) và \(w^i\) là vectơ riêng tương ứng với giá trị riêng lớn thứ i trong số tất cả các giá trị riêng của ma trận S.

Một cách khác để xem xét PCA

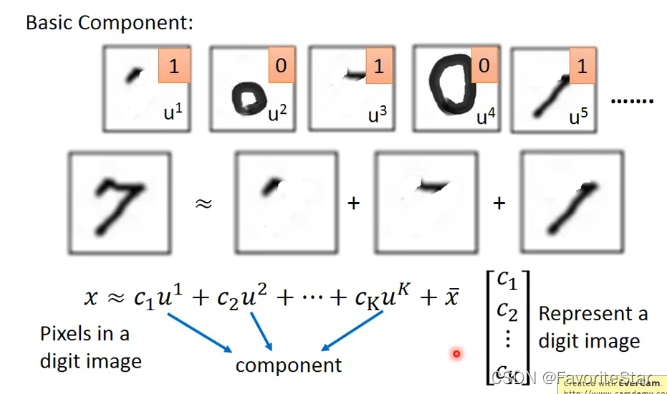

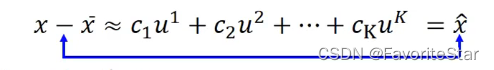

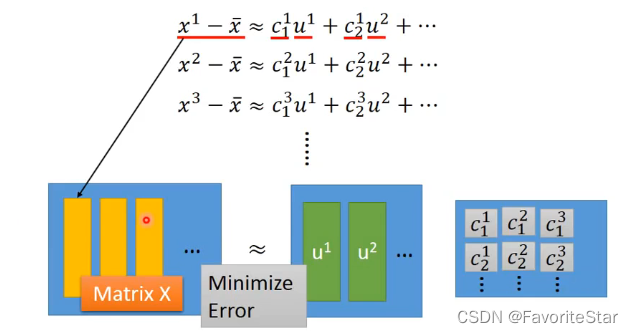

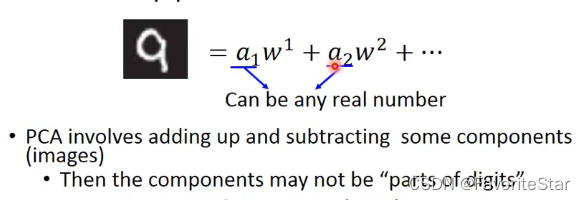

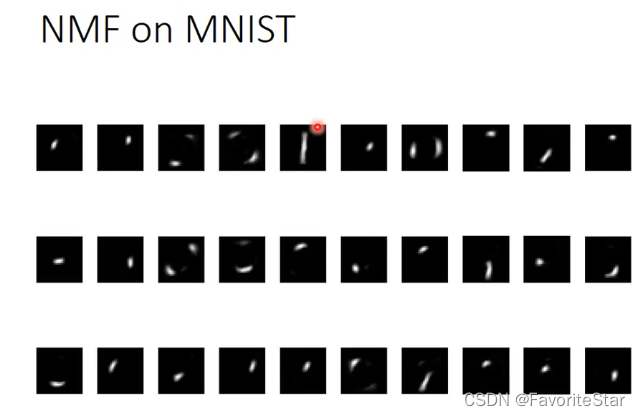

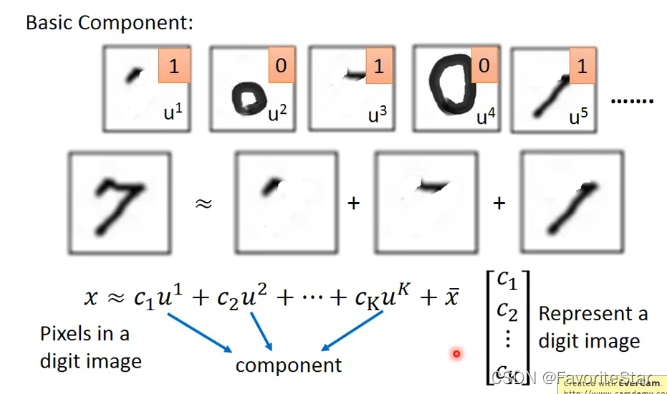

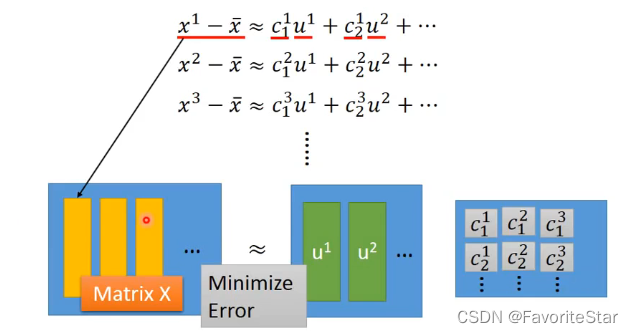

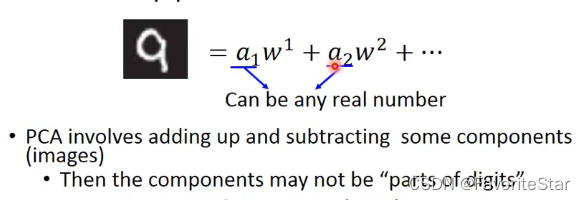

Giả sử rằng hiện tại có nhiều thành phần cơ bản và mỗi bức ảnh của chúng ta có thể được coi là tổng của nhiều thành phần và một giá trị trung bình cơ bản (giá trị trung bình của tất cả các mẫu). khác nhau thì một vectơ có thể được viết dựa trên việc có các thành phần cơ bản tương ứng trong ảnh\(C=[c_1,c_2,...]\) , nếu không có quá nhiều thành phần nhưng lại có nhiều hình ảnh thì việc chúng ta sử dụng vector C để biểu diễn một hình ảnh là rất có ý nghĩa.

Sau đó nó có thể được viết.

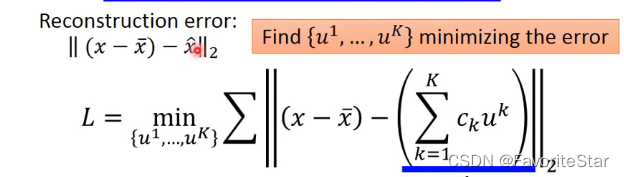

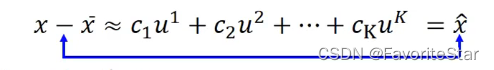

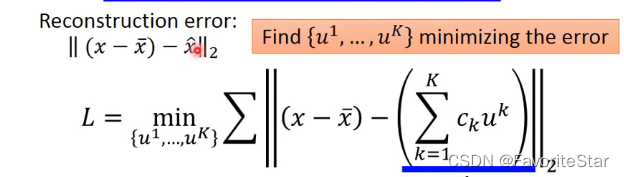

Do đó, ý tưởng của chúng tôi được chuyển thành việc tìm một tập hợp các vectơ \(\{u^1,u^2,...,u^k\}\) có thể tạo ra \(x-\bar{x}\) và Nghĩa là \( \hat{x}\) được giảm thiểu.

Có thể chứng minh rằng nhóm vectơ \(\{w^1,w^2,...,w^k\}\) tìm được bằng phương pháp PCA chính là nhóm vectơ đích mà chúng ta đang tìm kiếm. Và chuyển các phép toán trên sang dạng ma trận:

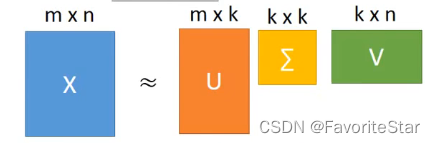

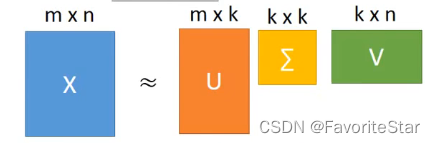

Mục tiêu là tìm ma trận u và ma trận c sao cho hiệu giữa chúng và ma trận X là nhỏ nhất sau khi nhân. Nhìn lại SVD chúng ta đã học, ma trận X có thể được phân tích:

Các vectơ k cột của ma trận U là k vectơ riêng lớn nhất của ma trận \(XX^T\), và \(XX^T\) là \(S=Cov(x)\), vì vậy đây là Chúng tôi muốn tìm \ (\{w^1,w^2,...w^k\}\), nhờ đó chúng ta có thể tìm thấy mục tiêu \(\{u^1,u^2,. ..u^k\}\) . Khi đó bài toán tiếp theo là giải ma trận C.

Vì chúng ta đã biết ma trận U nên đối với một mẫu nhất định, chúng ta có:

\[\hat{x}_i=\sum_{k=1}^K c^i_kw^k\approx x_i - \bar{x} \]

Vì mỗi vectơ trong ma trận W đều trực giao với nhau nên ta có:

\[c_k^i=(x_i-\bar{x})·w^k \]

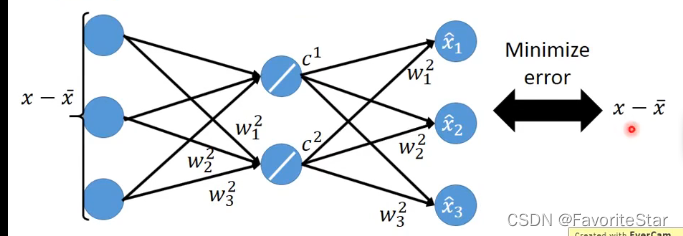

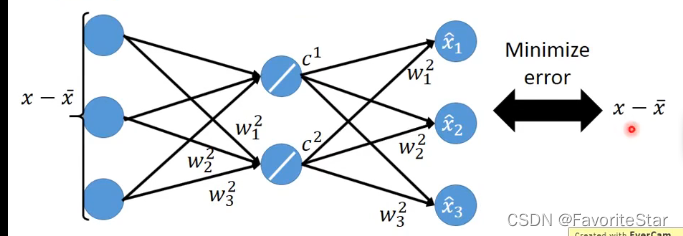

(mình chưa hiểu phần này lắm, mong bạn nào biết có thể hướng dẫn mình). Tiếp theo, quá trình này có thể được biểu diễn dưới dạng mạng nơ-ron: (lưu ý rằng c trong hình phải là chỉ số dưới, không phải chỉ số trên).

Nhưng nếu bây giờ chúng ta không giải ma trận W từ SVD mà giải nó thông qua việc giảm độ dốc từ mạng nơ-ron này, thì kết quả thu được theo cách này sẽ khác với kết quả thu được bằng SVD! Bởi vì các kết quả thu được trong SVD có hạn chế là chúng trực giao với nhau, còn mạng nơ-ron thì không. Cách nghĩ về PCA như một mạng lưới thần kinh với một lớp ẩn được gọi là Autoencoding.

Nhưng trên thực tế, phương pháp SVD giải quyết nhanh hơn và tốt hơn, và lý do để học phương pháp mạng thần kinh này là vì lớp ẩn của nó có thể được thêm vào để đạt được các hoạt động phức tạp hơn.

Nhược điểm của PCA

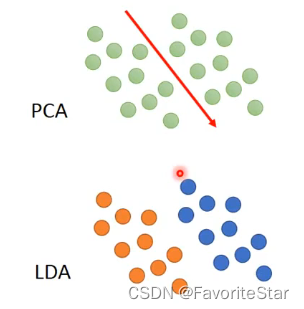

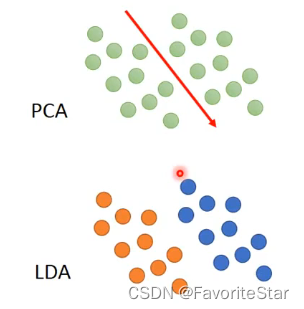

Đầu tiên là tính chất không được giám sát. Nếu bản thân mẫu có thông tin danh mục nhất định thì các vấn đề sau sẽ phát sinh:

Có thể thấy, nếu có các danh mục, PCA sẽ nhầm lẫn chúng với nhau.

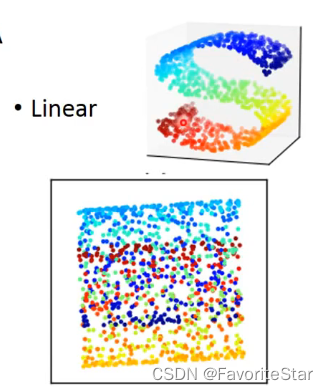

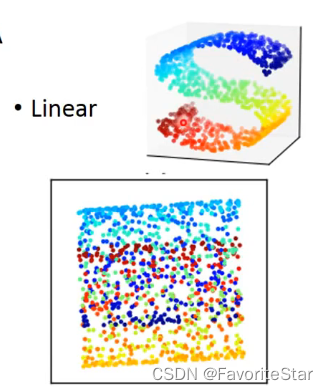

Thứ hai, đó là một phép biến đổi tuyến tính và không thể thực hiện những việc phi tuyến tính:

Ứng dụng của PCA

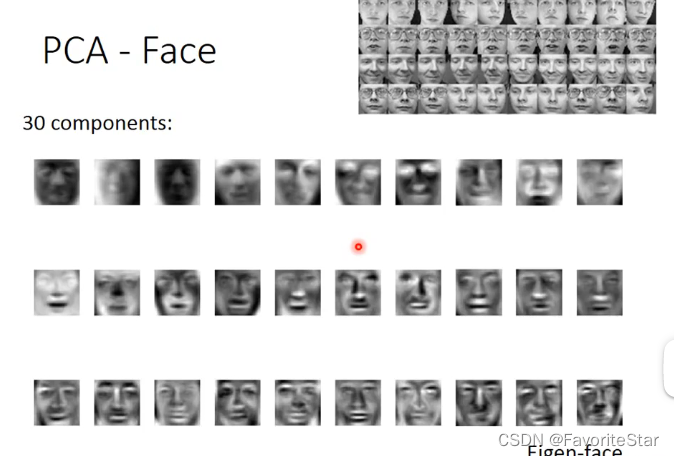

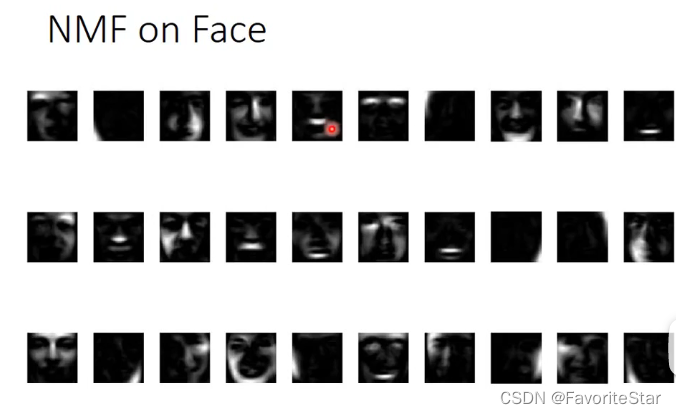

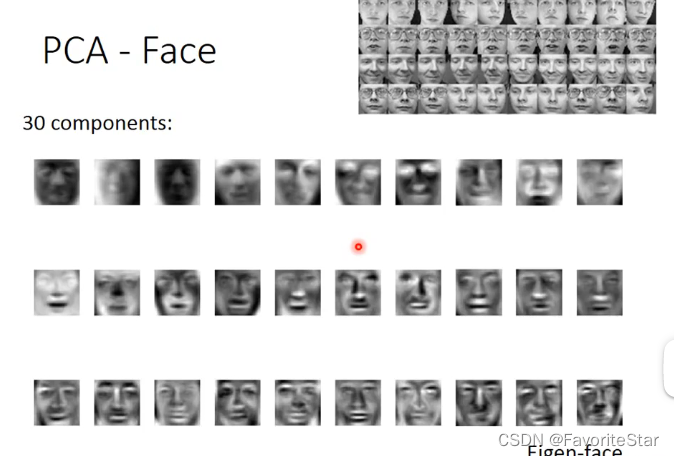

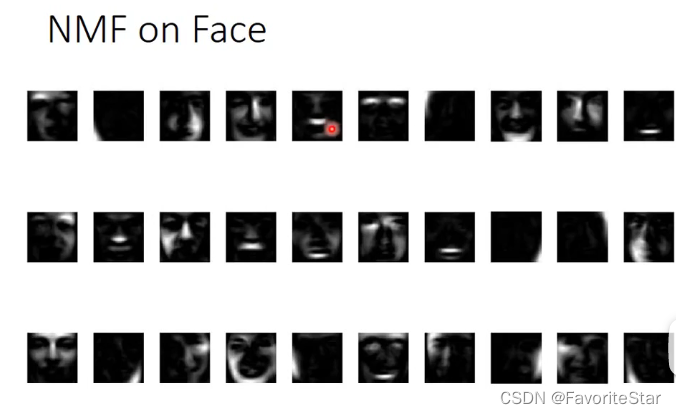

Nếu PCA được sử dụng để xử lý dữ liệu khuôn mặt:

Có thể thấy rằng mỗi vectơ đặc trưng không phải là thành phần cơ bản mà chúng ta tưởng tượng (như cái miệng hay thứ gì đó), mà giống một khuôn mặt hoàn chỉnh hơn.

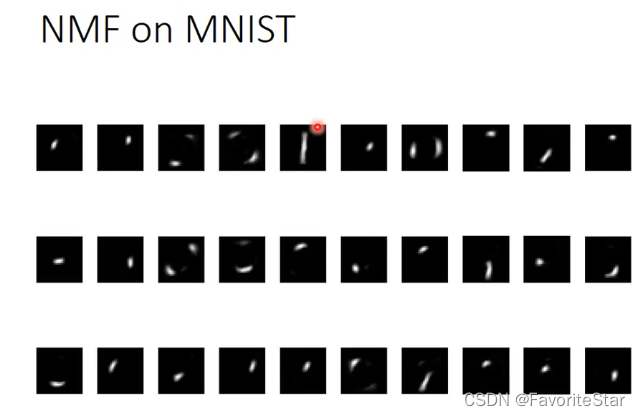

Bởi vì số có trọng số của các thành phần của các vectơ này không nhất thiết phải dương. Nếu chúng âm, nó tương đương với việc vẽ một thứ rất phức tạp trước rồi trừ đi một phần tử. Điều này rất không trực quan. Nếu bạn muốn các tham số có trọng số đều dương, bạn có thể sử dụng NMF, điều này có thể làm cho các tham số \(a_i\) đều dương và thứ hai, giá trị của từng thứ nguyên trong mỗi \(w^i\) là dương. PCA không thể đảm bảo điều đó, vì \(w^i\) trong ảnh tượng trưng cho thành phần thứ i của hình ảnh. Nếu một pixel nào đó âm, nó sẽ không được xử lý và PCA sẽ gặp vấn đề này.

Các thành phần có thể được nhìn thấy rõ ràng hơn, phù hợp với mong đợi của chúng tôi.

Cuối cùng, bài viết về [Học máy] Li Hongyi - Giảm kích thước tuyến tính kết thúc tại đây. Nếu bạn muốn biết thêm về [Học máy] Li Hongyi - Giảm kích thước tuyến tính, vui lòng tìm kiếm bài viết CFSDN hoặc duyệt các bài viết liên quan. bạn sẽ ủng hộ blog của tôi trong tương lai! .

Tôi là một lập trình viên xuất sắc, rất giỏi!